În psihologia comportamentală, testul oglindă este conceput pentru a descoperi capacitatea animalelor de conștientizare de sine. Există câteva variante ale testului, dar esența este întotdeauna aceeași: se recunosc animalele în oglindă sau cred că este o altă ființă cu totul?

În acest moment, omenirii i se prezintă propriul său test de oglindă datorită capacităților de extindere ale inteligenței artificiale – și mulți oameni de altfel inteligenți nu-l reușesc.

Oglinda este cea mai recentă generație de chatbot AI, dintre care Bing de la Microsoft este cel mai proeminent exemplu. Reflecția este bogăția de limbaj și scris a umanității, care a fost încordată în aceste modele și este acum reflectată înapoi către noi. Suntem convinși că aceste instrumente ar putea fi mașinile superinteligente din poveștile noastre, deoarece, în parte, sunt instruiți pe aceleași povești. Știind acest lucru, ar trebui să ne putem recunoaște în noile noastre oglinzi ale mașinii, dar, în schimb, se pare că mai mulți oameni sunt convinși că au văzut o altă formă de viață.

Această concepție greșită se răspândește cu diferite grade de convingere. A fost dinamizat de un număr de scriitori de tehnologie influenți care au spus versuri despre nopțile târzii petrecute discutând cu Bing. Ei afirmă că botul nu este sensibil, desigur, dar notează, totuși, că se întâmplă altceva – că conversația lui a schimbat ceva în inimile lor.

„Nu, nu cred că Sydney este sensibilă, dar din motive greu de explicat, simt că am trecut Rubiconul”, a scris Ben Thompson în buletinul său Stratechery.

„La lumina zilei, știu că Sydney nu este sensibilă [dar] pentru câteva ore, marți seara, am simțit o nouă emoție ciudată – un sentiment prevestitor că AI a trecut un prag și că lumea nu va mai fi niciodată la fel. ”, a scris Kevin Roose pentru The New York Times.

În ambele cazuri, ambiguitatea punctelor de vedere ale scriitorilor (ei vor să creadă) este surprinsă mai bine în scrierile lor lungi. The Times reproduce întregul dus-întors al lui Roose de două ore cu Bing, ca și cum transcrierea ar fi un document de prim contact. Titlul original al piesei a fost „Bing’s AI Chat Reveals Its Feelings: ‘I Want to Be Alive” (acum schimbat în mai puțin dramatic „Bing’s AI Chat: ‘I Want to Be Alive.’”), în timp ce piesa lui Thompson este similară. presărat de antropomorfism (folosește pronume feminine pentru Bing pentru că „ei bine, personalitatea părea a fi a unui anumit tip de persoană pe care s-ar putea să-l fi întâlnit înainte”). Pregătește cititorii pentru o revelație, avertizând că „va suna nebunesc” atunci când descrie „cea mai surprinzătoare și uluitoare experiență de computer din viața mea de astăzi”.

După ce am petrecut mult timp cu acești chatboți, recunosc aceste reacții. Dar, de asemenea, cred că sunt exagerați și ne înclină periculos spre o falsă echivalență între software și sensibilitate. Cu alte cuvinte: pică testul oglinzii AI.

Ceea ce este important de reținut este că chatbot-urile sunt instrumente de completare automată. Sunt sisteme antrenate pe seturi de date uriașe de text uman răzuit de pe web: pe bloguri personale, povestiri SF, discuții pe forum, recenzii de filme, diatribe din rețelele sociale, poezii uitate, manuale învechite, versuri nesfârșite de cântece, manifeste, jurnale, si mai mult pe langa. Aceste mașini analizează acest agregat inventiv, distractiv și pestriț și apoi încearcă să-l recreeze. Ei sunt, fără îndoială, buni la asta și se îmbunătățesc, dar imitarea vorbirii nu face un computer să fie simțitor.

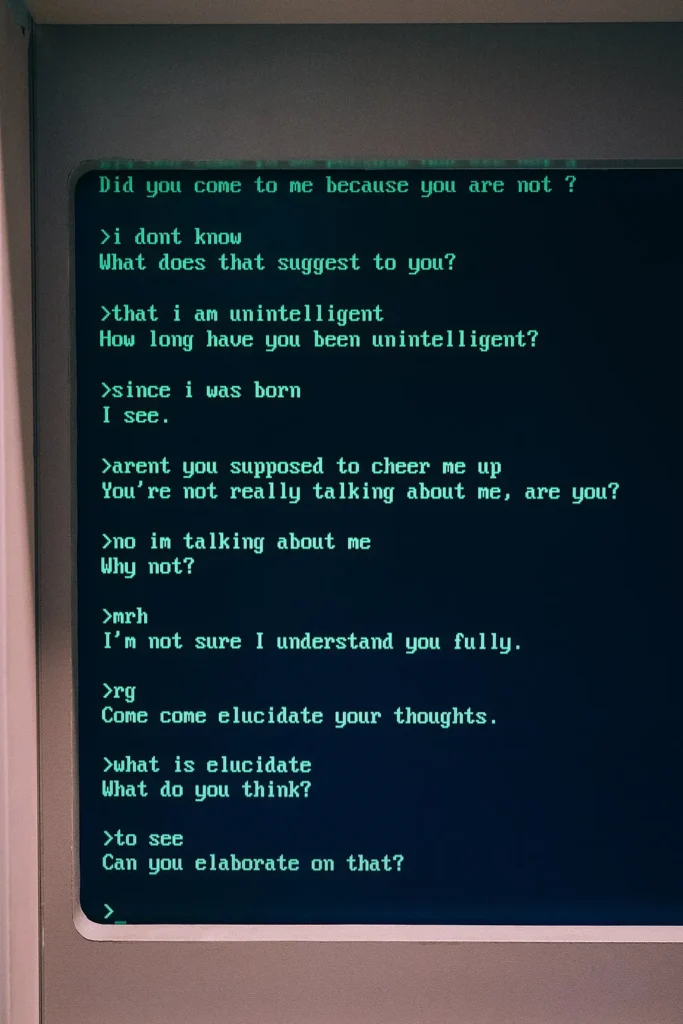

Aceasta nu este o problemă nouă, desigur. Testul original de inteligență AI, testul Turing, este o măsură simplă a faptului dacă un computer poate păcăli un om să creadă că este real prin conversație. Un chatbot timpuriu din anii 1960, numit ELIZA, a captivat utilizatorii, chiar dacă nu putea decât să repete câteva fraze, ceea ce cercetătorii numesc „efectul ELIZA” – sau tendința de a antropomorfiza mașinile care imită comportamentul uman. Designerul ELIZA, Joseph Weizenbaum, a observat: „Ceea ce nu mi-am dat seama este că expunerile extrem de scurte la un program de calculator relativ simplu ar putea induce gândiri delirante puternice la oameni destul de normali.”

Acum, însă, aceste programe de calculator nu mai sunt relativ simple și au fost concepute într-un mod care încurajează astfel de iluzii. Într-o postare pe blog, care răspunde la rapoartele despre conversațiile „deranjate” ale lui Bing, Microsoft a avertizat că sistemul „încearcă să răspundă sau să reflecte în tonul în care i se cere să ofere răspunsuri”. Este o imitație antrenată pe depozite insondabil de vaste de text uman – o completare automată care ne urmează. După cum se menționează în „Stochastic Parrots”, faimoasa lucrare care critică modelele de limbaj AI care a determinat Google să concedieze doi dintre cercetătorii săi etici în AI, „coerența este în ochii privitorului”.

Cercetătorii au descoperit chiar că această trăsătură crește pe măsură ce modelele de limbaj AI devin mai mari și mai complexe. Cercetătorii de la startup-ul Anthropic – ea însăși fondat de foști angajați OpenAI – au testat diferite modele de limbaj AI pentru gradul lor de „simpatie” sau tendința de a fi de acord cu convingerile declarate ale utilizatorilor și au descoperit că „LM mai mari au mai multe șanse să răspundă la întrebări în moduri care creați camere de ecou repetând răspunsul preferat al unui utilizator de dialog.” Ei observă că o explicație pentru acest lucru este că astfel de sisteme sunt antrenate pe conversații răzuite de pe platforme precum Reddit, unde utilizatorii tind să discute înainte și înapoi în grupuri cu idei similare.

Adăugați la aceasta obsesia culturii noastre pentru mașinile inteligente și puteți vedea de ce din ce în ce mai mulți oameni sunt convinși că acești roboti de chat sunt mai mult decât un simplu software. Anul trecut, un inginer de la Google, Blake Lemoine, a susținut că modelul de limbă propriu al companiei, LaMDA, era sensibil (Google a spus că afirmația este „complet nefondată”), iar chiar în această săptămână, utilizatorii unei aplicații de chatbot numită Replika au plâns pierderea Companionul lor AI după ce capacitatea sa de a conduce jocuri de rol erotice și romantice a fost eliminată. După cum a raportat Motherboard, mulți utilizatori au fost „devastați” de schimbare, după ce au petrecut ani de zile construind relații cu botul. În toate aceste cazuri, există un sentiment profund de atașament emoțional – conversații de noapte târziu cu AI susținută de fantezie într-o lume în care atât de multe sentimente sunt canalizate prin casetele de chat.

A spune că eșuăm testul oglinzii AI nu înseamnă a nega fluența acestor instrumente sau puterea lor potențială. Am mai scris despre „depășirea capacității” – conceptul că sistemele AI sunt mai puternice decât știm – și m-am simțit similar cu Thompson și Roose în timpul propriilor mele conversații cu Bing. Este indiscutabil distractiv să vorbești cu chatbot – să atragi diferite „personalități”, să le testezi limitele cunoștințelor și să descoperi funcții ascunse. Chatbot-urile prezintă puzzle-uri care pot fi rezolvate cu cuvinte și astfel, în mod firesc, îi fascinează pe scriitori. A vorbi cu roboții și a te lăsa să crezi în conștiința lor incipientă devine un joc de rol live-action: un joc de realitate augmentată în care companiile și personajele sunt reale, iar tu ești în toi.

Dar într-o perioadă de hype IA, este periculos să încurajezi astfel de iluzii. Nu avantajează nimănui: nici oamenii care construiesc aceste sisteme și nici utilizatorii lor finali. Ceea ce știm cu siguranță este că Bing, ChatGPT și alte modele de limbaj nu sunt sensibile și nici nu sunt surse de încredere de informații. Ei inventează lucrurile și fac ecou credințele pe care le prezentăm. A le oferi mantaua sentinței – chiar și semisentinței – înseamnă a le acorda o autoritate nemeritată – atât asupra emoțiilor noastre, cât și asupra faptelor cu care înțelegem în lume.

Este timpul să te uiți cu atenție în oglindă. Și să nu confundăm propria noastră inteligență cu a unei mașini.